Last Updated on Februar 27, 2024 12:43 pm by Laszlo Szabo / NowadAIs | Published on Februar 5, 2024 by Juhasz “the Mage” Gabor

OpenAIs militärisches Verbot stillschweigend aufgehoben – Offene Türen für KI-gesteuerte Schlachtfelder? – Wichtige Hinweise:

- Politikwechsel: OpenAI hebt das Verbot der militärischen Nutzung seiner KI-Tools auf.

- Militärische Partnerschaften: Mögliche Zusammenarbeit mit Verteidigungsministerien, einschließlich des US-Verteidigungsministeriums.

- Ethische Bedenken: Debatte über KI in der Kriegsführung, zivile Sicherheit und KI-Voreingenommenheit.

- Der Standpunkt von OpenAI: Betonung auf Nicht-Schaden und Verbot der Waffenentwicklung.

- Zukünftige Implikationen: Die Entscheidung hat Auswirkungen auf die Rolle der KI in militärischen Anwendungen und wirft Fragen zu ethischen Richtlinien auf.

Die Kehrtwende von OpenAI

OpenAI, das führende KI-Unternehmen, hat einen bedeutenden Politikwechsel vollzogen, indem es das Verbot der militärischen Nutzung seiner fortschrittlichen KI-Tools stillschweigend aufgehoben hat. Diese Entscheidung hat die Aufmerksamkeit des Pentagon auf sich gezogen und Fragen zu den möglichen Auswirkungen und Konsequenzen aufgeworfen.

Im Folgenden werden wir uns mit den Details der Änderung der OpenAI-Politik, den damit verbundenen Bedenken und den möglichen Auswirkungen auf die Zukunft der KI in militärischen Anwendungen befassen.

Das Verbot der militärischen Nutzung

Bis vor kurzem hatte OpenAI strenge Richtlinien, die die Nutzung ihrer Technologie für militärische und kriegerische Zwecke untersagten:

“Aktivitäten, die ein hohes Risiko für körperlichen Schaden haben”

Die Richtlinien des Unternehmens besagten ausdrücklich, dass seine Modelle, wie ChatGPT, nicht für Aktivitäten verwendet werden sollten, die ein hohes Risiko körperlicher Schäden bergen, einschließlich Waffenentwicklung und militärischer Anwendungen.

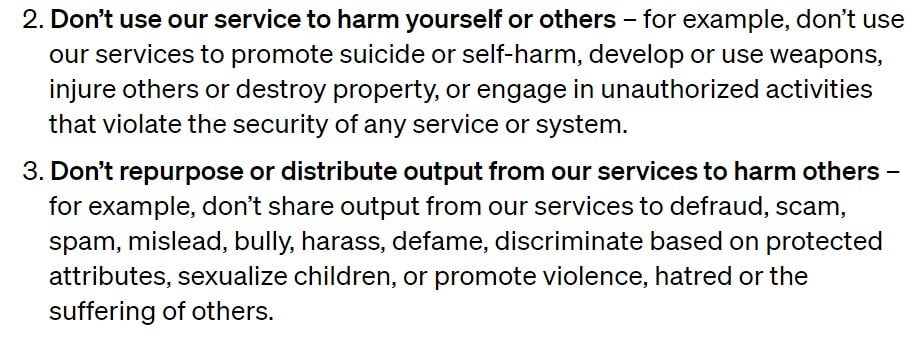

OpenAI hat nun jedoch den ausdrücklichen Verweis auf das Militär aus seinen Richtlinien entfernt, betont aber weiterhin das Verbot, seine Tools zu verwenden, um sich selbst oder andere zu verletzen und Waffen zu entwickeln oder einzusetzen.

Die Streichung des Verbots der militärischen Nutzung wird als deutliche Abkehr von der bisherigen Haltung von OpenAI angesehen und hat bei Experten und Beobachtern gleichermaßen Besorgnis ausgelöst.

Die Richtlinienänderung öffnet die Tür für potenzielle Partnerschaften zwischen OpenAI und Verteidigungsministerien, einschließlich des US-Verteidigungsministeriums, das Interesse an der Nutzung generativer KI für Verwaltungs- und Geheimdienstoperationen bekundet hat.

Die Auswirkungen und Kritikpunkte

Die Änderung der Politik von OpenAI hat eine Debatte über die ethischen Implikationen von KI in militärischen Anwendungen ausgelöst.

Kritiker argumentieren, dass der Einsatz von KI in der Kriegsführung Bedenken hinsichtlich ziviler Opfer, Verzerrungen in KI-Systemen und einer möglichen Eskalation von Waffenkonflikten aufwirft.

Sie weisen darauf hin, dass die Ergebnisse von KI-Modellen wie ChatGPT zwar oft überzeugend sind, dass sie aber der Kohärenz Vorrang vor der Genauigkeit einräumen und unter Halluzinationen leiden können, die zu ungenauen und voreingenommenen Operationen führen können.

OpenAIs Antwort und Klarheit

Der Sprecher von OpenAI, Niko Felix, stellte klar, dass die Änderung der Richtlinien dazu diente, Klarheit zu schaffen und Diskussionen über Anwendungsfälle im Bereich der nationalen Sicherheit zu ermöglichen, die mit der Mission von OpenAI übereinstimmen:

Wir wollten eine Reihe von universellen Prinzipien schaffen, die leicht zu merken und anzuwenden sind, vor allem, da unsere Werkzeuge nun weltweit von alltäglichen Nutzern verwendet werden, die nun auch GPTs erstellen können. Ein Grundsatz wie “Du sollst anderen keinen Schaden zufügen” ist weit gefasst, aber leicht zu verstehen und in vielen Kontexten relevant. Außerdem haben wir Waffen und die Verletzung anderer als klare Beispiele angeführt.

Er erwähnte die Zusammenarbeit mit der Defense Advanced Research Projects Agency (DARPA) zur Entwicklung von Cybersicherheitstools für kritische Infrastrukturen und die Industrie. Ziel dieser Zusammenarbeit ist die Sicherung von Open-Source-Software, die für die nationale Sicherheit von entscheidender Bedeutung ist.

Felix erklärte, dass OpenAI sich der Risiken und Schäden bewusst ist, die mit militärischen Anwendungen ihrer Technologie verbunden sind.

Während die Aktualisierung der Richtlinie das ausdrückliche Verbot von Militär und Kriegsführung aufhebt, gilt der Grundsatz, sich selbst und anderen keinen Schaden zuzufügen, weiterhin.

Jegliche Nutzung der Technologie von OpenAI, auch durch das Militär, um Waffen zu entwickeln oder einzusetzen, andere zu verletzen oder sich an nicht autorisierten Aktivitäten zu beteiligen, die die Sicherheit eines Dienstes oder Systems verletzen, ist untersagt.

Die Rolle der KI im Militär

Das Militär hat das Potenzial von KI für verschiedene Anwendungen erforscht.

Auch wenn die Technologie von OpenAI nicht direkt tödliche Aktionen ermöglicht, kann sie doch für Aufgaben eingesetzt werden, die mit dem Töten zusammenhängen, wie das Schreiben von Code oder die Bearbeitung von Beschaffungsaufträgen.

Experten argumentieren jedoch, dass die Tools von OpenAI selbst dann, wenn sie in einer militärischen Einrichtung für gewaltfreie Zwecke eingesetzt würden, einen Beitrag zu einer Organisation leisten würden, deren Hauptzweck die Tötung ist.

Die Einbeziehung von KI in militärische Nachrichtendienste, Zielsysteme und Entscheidungshilfen wirft Bedenken hinsichtlich der Genauigkeit, der Voreingenommenheit und des Potenzials für unbeabsichtigte Folgen auf.

Der Bedarf an ethischen Richtlinien

Der Politikwechsel von OpenAI unterstreicht die Bedeutung klarer undumfassender ethischer Richtlinien für den Einsatz von KI, insbesondere im militärischen Kontext.

Da die KI-Technologie weiter voranschreitet, ist es von entscheidender Bedeutung, sich mit den potenziellen Risiken und Auswirkungen ihres Einsatzes in der Kriegsführung auseinanderzusetzen.

Sarah Myers West, Geschäftsführerin des AI Now Institute, betont die Notwendigkeit von Transparenz und Durchsetzung der Politik von OpenAI:

Prof. Suchman questions notions of who constitutes an “imminent threat” that are baked into AI-enabled warfighting”, and the legitimacy of this targeting under the Geneva Convention.

2/

— AI Now Institute (@AINowInstitute) January 26, 2024

Die vage Formulierung wirft Fragen darüber auf, wie OpenAI die Durchsetzung der Bestimmungen angehen will und ob es die Herausforderungen, die sich aus militärischen Aufträgen und Kriegseinsätzen ergeben, effektiv bewältigen kann.

Schlussfolgerung

Die Entscheidung von OpenAI, das Verbot der militärischen Nutzung seiner KI-Tools aufzuheben, hat Diskussionen über die Überschneidung von KI und Kriegsführung ausgelöst.

Während das Unternehmen versucht, Klarheit zu schaffen und Anwendungsfälle für die nationale Sicherheit zuzulassen, bleiben Bedenken über die möglichen Folgen und ethischen Implikationen von KI in militärischen Anwendungen bestehen.

Da sich der Bereich der KI weiter entwickelt, ist es für Organisationen wie OpenAI wichtig, solide ethische Richtlinien aufzustellen und eine verantwortungsvolle Entwicklung und Anwendung von KI-Technologie zu gewährleisten.

Die Abwägung der Vorteile und Risiken von KI im militärischen Kontext ist eine komplexe Aufgabe, die eine sorgfältige Abwägung und gründliche Bewertung der potenziellen Auswirkungen auf Menschenleben und die globale Sicherheit erfordert.