Last Updated on febrero 27, 2024 12:40 pm by Laszlo Szabo / NowadAIs | Published on febrero 5, 2024 by Juhasz “the Mage” Gabor

Se levanta en silencio la prohibición militar de OpenAI: ¿puertas abiertas para los campos de batalla impulsados por la IA? – Notas clave:

- Cambio de política: OpenAI elimina la prohibición del uso militar de sus herramientas de IA.

- Asociaciones militares: Posible colaboración con departamentos de defensa, incluido el Departamento de Defensa de Estados Unidos.

- Preocupaciones éticas: Debate sobre la IA en la guerra, la seguridad de los civiles y los prejuicios de la IA.

- Posición de OpenAI: Énfasis en no dañar y prohibición del desarrollo de armas.

- Implicaciones futuras: La decisión afecta al papel de la IA en aplicaciones militares y plantea cuestiones sobre directrices éticas.

Acerca de OpenAI

OpenAI, la empresa líder en IA, ha dado un giro significativo en su política al eliminar discretamente su prohibición de uso militar de sus herramientas avanzadas de IA. Esta decisión ha llamado la atención del Pentágono y ha suscitado preguntas sobre las posibles implicaciones y consecuencias.

A continuación profundizaremos en los detalles del cambio de política de OpenAI, las inquietudes que suscita y el impacto que puede tener en el futuro de la IA en las aplicaciones militares.

La prohibición del uso militar

Hasta hace poco, OpenAI tenía directrices estrictas que prohibían el uso de su tecnología para fines militares y bélicos, utilizaban el término:

“actividad que tiene un alto riesgo de daño físico”

Las políticas de la compañía establecían explícitamente que sus modelos, como ChatGPT, no deberían utilizarse para actividades que supongan un alto riesgo de daño físico, incluyendo el desarrollo de armas y aplicaciones militares.

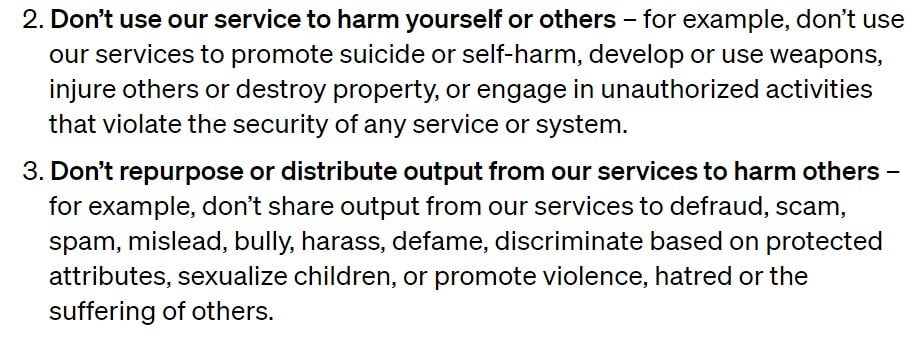

Sin embargo, OpenAI ha eliminado ahora de sus políticas la referencia específica a los militares, aunque sigue insistiendo en la prohibición de utilizar sus herramientas para hacerse daño a uno mismo o a otros y desarrollar o utilizar armas.

La eliminación de la prohibición del uso militar se considera una desviación significativa de la postura anterior de OpenAI y ha suscitado preocupación entre expertos y observadores.

El cambio de política abre la puerta a posibles colaboraciones entre OpenAI y los departamentos de defensa, incluido el Departamento de Defensa de Estados Unidos, que ha expresado su interés en utilizar la IA generativa para operaciones administrativas y de inteligencia.

Implicaciones y críticas

El cambio de política de OpenAI ha suscitado un debate sobre las implicaciones éticas de la IA en aplicaciones militares.

Los críticos sostienen que el uso de la IA en la guerra suscita preocupación por las víctimas civiles, los sesgos de los sistemas de IA y la posible escalada de los conflictos armamentísticos.

Señalan que los resultados de modelos de IA como ChatGPT, aunque a menudo convincentes, dan prioridad a la coherencia sobre la precisión y pueden sufrir alucinaciones que lleven a operaciones imprecisas y sesgadas.

Respuesta y claridad de OpenAI

El portavoz de OpenAI, Niko Felix, aclaró que el cambio de política pretendía proporcionar claridad y permitir debates en torno a casos de uso de seguridad nacional que se alinean con la misión de OpenAI:

Nuestro objetivo era crear un conjunto de principios universales que fueran fáciles de recordar y aplicar, sobre todo teniendo en cuenta que nuestras herramientas ya son utilizadas en todo el mundo por usuarios cotidianos que ahora también pueden crear GPT. Un principio como “No hagas daño a los demás” es amplio, pero fácil de comprender y pertinente en numerosos contextos. Además, citamos específicamente las armas y los daños a terceros como ejemplos claros”.

Mencionó su colaboración con la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA) para desarrollar herramientas de ciberseguridad para infraestructuras críticas y la industria. El objetivo de esta colaboración es asegurar el software de código abierto, crucial para la seguridad nacional.

Felix afirmó que OpenAI es consciente de los riesgos y daños asociados a las aplicaciones militares de su tecnología.

Aunque la actualización de la política elimina la prohibición explícita de aplicaciones militares y bélicas, el principio de no causar daño a uno mismo o a otros sigue siendo aplicable.

Cualquier uso de la tecnología de OpenAI, incluido el militar, para desarrollar o utilizar armas, herir a otros o participar en actividades no autorizadas que violen la seguridad de cualquier servicio o sistema, está prohibido.

El papel de la IA en el ejército

Los militares han estado explorando el potencial de la IA para diversas aplicaciones.

Aunque la tecnología de OpenAI no permita directamente realizar acciones letales, puede utilizarse en tareas relacionadas con la muerte, como escribir código o procesar órdenes de compra.

Por ejemplo, el personal militar ya ha utilizado bots personalizados impulsados por ChatGPT para agilizar el papeleo.

Sin embargo, los expertos sostienen que incluso si las herramientas de OpenAI se desplegaran con fines no violentos dentro de una institución militar, seguirían contribuyendo a una organización cuyo objetivo principal es la letalidad.

La implicación de la IA en la inteligencia militar, los sistemas de selección de objetivos y el apoyo a la toma de decisiones suscita preocupación por la precisión, los sesgos y las posibles consecuencias no deseadas.

Necesidad de directrices éticas

El cambio de política de OpenAI pone de relieve la importancia de establecerdirectrices éticas claras yexhaustivas para el uso de la IA, especialmente en contextos militares.

A medida que la tecnología de IA sigue avanzando, es crucial abordar los riesgos potenciales y las implicaciones asociadas a su despliegue en la guerra.

Sarah Myers West, directora gerente del AI Now Institute, subraya la necesidad de transparencia y cumplimiento de la política de OpenAI:

Prof. Suchman questions notions of who constitutes an “imminent threat” that are baked into AI-enabled warfighting”, and the legitimacy of this targeting under the Geneva Convention.

2/

— AI Now Institute (@AINowInstitute) January 26, 2024

La vaguedad del lenguaje suscita dudas sobre cómo pretende OpenAI enfocar el cumplimiento de la ley y si puede sortear con eficacia los retos que plantean la contratación militar y las operaciones bélicas.

Conclusión

La decisión de OpenAI de eliminar la prohibición del uso militar de sus herramientas de IA ha suscitado debates sobre la intersección de la IA y la guerra.

Aunque la empresa pretende aportar claridad y permitir casos de uso para la seguridad nacional, persiste la preocupación por las posibles consecuencias e implicaciones éticas de la IA en aplicaciones militares.

A medida que el campo de la IA sigue evolucionando, es esencial que organizaciones como OpenAI establezcan directrices éticas sólidas y garanticen el desarrollo y despliegue responsables de la tecnología de IA.

Equilibrar los beneficios y los riesgos de la IA en contextos militares es una tarea compleja que requiere una consideración cuidadosa y una evaluación exhaustiva del impacto potencial sobre las vidas humanas y la seguridad mundial.